-

Sándorné Szatmári: @CIkk: Mende Balázs Gusztáv kutató csoportja írta "..az avarok anyai ágú etnogenezise egys...2025. 07. 15, 14:43 2. rész: nomád régészeti konferencia...

-

ganajtúrós bukta: Most találtam a wikiben: "Ugyanez a genom 50% manysi (finnugor), 35% szarmata (indoiráni) ...2025. 07. 12, 20:34 Mi bizonyítja, hogy a magyar nyelv finnugor?

-

ganajtúrós bukta: @Sándorné Szatmári: Amúgy nincs kedved kalandmesternek jelentkezni a legközelebbi m.a.g.u....2025. 07. 09, 18:00 Mi bizonyítja, hogy a magyar nyelv finnugor?

-

szigetva: @Sándorné Szatmári: Egyetlen konkrétum van a hosszú szövegedben: a magyarban E3-ban nincs ...2025. 07. 09, 11:17 Mi bizonyítja, hogy a magyar nyelv finnugor?

-

Sándorné Szatmári: @ganajtúrós bukta: Idézet a cikkből: "...erősen kritizálják a nyelvcsalád fogalmát. Ennek ...2025. 07. 09, 10:23 Mi bizonyítja, hogy a magyar nyelv finnugor?

Kálmán László nyelvész, a nyest szerkesztőségének alapembere, a hazai nyelvtudomány és nyelvi ismeretterjesztés legendás alakjának rovata volt ez.

- Elhunyt Kálmán László, a Nyelvész, aki megmondja

- Így műveld a nyelvedet

- Utoljára a bicigliről

- Start nyelvstratégia!

- Változás és „igénytelenség”

Kálmán László korábbi cikkeit itt találja.

Ha legutóbb kimaradt, most itt az új lehetőség!

Ha ma csak egyetlen nyelvészeti kísérletben vesz részt, mindenképp ez legyen az!

Finnugor nyelvrokonság: hazugság

A határozott névelő, ami azt jelenti, hogy ‘te’

Az oroszok már a fejünkön vannak!

Vajon szabályos rendszer a nyelv, vagy pusztán benyomásaink lenyomata? Eldönthető-e egyértelműen, hogy egy mondat helyes-e vagy nem? Mi közük a legmodernebb nyelvtechnológiai módszereknek a 17. századi filozófiai vitákhoz? Történeti áttekintés a nyesttől is szokatlan komolysággal és terjedelemben.

A számítógépes nyelvészet fő célja egy olyan rendszer építése, amely

fel tud dolgozni és elő tud állítani természetes emberi nyelvi

kifejezéseket (szavakat, mondatokat, szövegeket) – erős

megfogalmazásban úgy, ahogy azt az ember teszi. Ennek megvalósulására példát egyelőre csak sci-fikben láttunk, leghíresebb képviselője HAL 9000, a 2001: Űrodüsszeia című film gonosz számítógépe.

(Forrás: Wikimedia commons)

A nagy cél eléréséhez természetesen sokféle út vezet, de ezeket két két nagy irányzatba sorolhatjuk. A két irányzat szembenállása határozta meg az elmúlt évtizedekben a számítógépes nyelvészet szakterületét, ezért a szakirodalom is előszeretettel értekezik róla. Az ellentét lényege több fogalompárral is kifejezhető: filozófiai aspektusból racionalista és empirista megközelítésről beszélhetünk, a metodológia az elmélet- és adatorientáltság különbségéről szól, a technikák terén pedig a szimbolikus és a statisztikai jelzőket használják. Nem kell megijedni, ezek a fogalmak alapjában véve nem bonyolult dolgokat takarnak, amint az az alábbiakból mindjárt ki is derül.

Egy kis őstörténet: az 1940–50-es évek

A számítástechnika fejlődése a 2. világháború utáni években kapott nagy lendületet, természetesen a katonai célú fejlesztéseknek köszönhetően. Az ebben a periódusban született munkákat két paradigma, azaz tudományos nézetrendszer határozta meg: az automataelmélet és a valószínűségi vagy információelméleti modellek.

Az automataelmélet – és egyesek szerint az egész számítástechnika – Alan Turing munkásságán, pontosabban a Turing-gép ötletén alapul, és ez vezetett Stephen Kleene munkájához is a véges állapotú automatákról és a reguláris kifejezésekről. 1948-ban Claude Shannon diszkrét Markov-modellek valószínűségi modelljét alkalmazta a nyelv modellálását célzó automatákra.

(Forrás: Wikimedia commons)

Ja, hogy ez kissé kínaiul van? Nos, nem kell megijedni, mindez csupán azt jelenti, hogy a kutatók úgy képzelték el a nyelv működését, mint egy automatáét, mely a nyelv apróbb elemeiből (szótövekből, toldalékokból) építi fel a mondatokat. Ezeket a szabályokat pedig matematikai függvényként képzelték el, melyek változóiba a nyelvi elemek behelyettesíthetők. Egy egyszerűsített példával élve: az ad ige egy olyan függvény, melynek három változója van: egy esetraggal el nem látott (azaz alanyesetben álló) főnév, egy –nak/-nek ragos (azaz részes esetben álló főnév), illetve egy –t ragos (azaz tárgyesetben álló) főnév.

Shannon munkájából kiindulva Chomsky alkalmazta először a véges állapotú gépeket nyelvek meghatározására; a róla elnevezett nyelvhierarchiának minden lépcsőjén véges állapotú nyelvek találhatók, melyeket a nekik megfelelő véges állapotú gépek generálnak. Azaz fenti példánkat kiegészítve: az ad igével alkotott mondatokban nem csupán főnevek állhatnak (Géza könyvet ad Annának), hanem a főnevek különbözőképpen bővíthetőek, pl. melléknevekkel (érdekes könyv), számnevekkel (két könyv) stb. Ezek a szabályok azonban már nem módosítják az adra vonatkozó szabályokat, hanem ezek eredményei, azaz kimenetei válnak a másik szabály bemeneti értékeivé, azaz változójává: így jöhet létre például a Géza két érdekes könyvet ad Annának mondat – és sokkal bonyolultabb mondatok is.

Ezek a korai modellek vezettek a formális nyelvek elméletének kialakulásához, mely az algebra és a halmazelmélet eszközeit használta a formális nyelvek mint szimbólumsorozatok, karakterfüzérek definiálásához. Ez azt jelenti, hogy a számítógép a megadott betűsorokat bonyolult matematikai képletnek fogja fel.

A korszak másik paradigmája a valószínűségszámítási algoritmusok használata a beszéd- és nyelvfeldolgozásban. Ez szintén Shannon nevéhez köthető, aki 1949-ben állította fel modelljét a kommunikációról mint általános hírközlési rendszerről. Itt fejti ki azt a metaforát, mely szerint a természetesnyelv-feldolgozási problémák megfeleltethetők dekódolási problémáknak a zajos kommunikációs csatornában: azaz a probléma nehézségét az okozza, hogy az érdemi információt el kell választani a zavaró körülményektől. Másik nagy találmánya az entrópia fogalmának kikölcsönzése a termodinamikából és bevezetése mint a kommunikációs csatorna információs kapacitásának mérőeszköze. Ezek a fogalmak jelentik a későbbi statisztikai alapú számítógépes nyelvészeti alkalmazások alapját.

Az ókor: 1957–1970

Az 50-es évek végére, illetve a 60-as évek elejére a beszéd- és nyelvfeldolgozó alkalmazások két tisztán különválasztható paradigmára estek, ezek: a szimbolikus és a sztochasztikus.

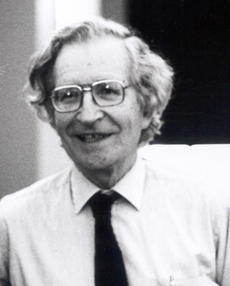

A szimbolikus paradigma (mely lényegében az automataelmélet folytatása) egyik szála Chomsky generatív mondattani kutatásaihoz fűződik. Chomsky újradefiniálta a nyelvészet feladatát: a nyelvésznek nem a nyelvi jelenségek leírása a feladata, hanem annak a vizsgálata, hogy hogyan tanulja meg a gyerek a nyelvet, és mik azok a jegyek, amelyek minden nyelvben közösek. Márpedig ezek a jelenségek a nyelv felszíni megjelenésétől igen távol esnek, így a „sekély” korpuszalapú (azaz nagy mennyiségű szöveg alapján elvégzett) módszerekkel nem elérhetőek. Mindemellett Chomsky az ellen érvelt, hogy a nyelv megtanulható lenne az elérhető nyelvi adatokból: szerinte a nyelv velünk született. Természetesen nem a konkrét (angol, magyar stb.) nyelvre gondolt, hanem az emberi nyelvre általában. Szerinte minden emberi nyelv lényegileg azonos, és a gyermek nyelvtanuláskor csak szavakat tanul, ill. nyelvtani „kapcsolókat” állít be annak alapján, amit tapasztal.

(Forrás: Wikimedia commons)

Chomsky érvelései érthető okokból teljesen visszavetették az empirikus kutatásokat, és a nyelvészeti tanulmányok fókuszát a racionalista módszerekre irányították. (Hogy milyen értelemben „racionalista”, arról nemsokára szót ejtünk.)

A szimbolikus paradigma másik szála a mesterséges intelligencia (MI) új területe volt. Ez utóbbi fókuszában inkább a következtetés és a logika állt, mintsem a sztochasztikus és statisztikai algoritmusok. A korai MI-kutatások a racionalista megközelítést követték abban az értelemben, hogy a nyelvi tudás szabályalapú reprezentációját használták (azaz úgy vélték, hogy a nyelvi tudás lényegében szabályok ismerete).

A sztochasztikus, azaz a véletlenszerűségre építő paradigma a valószínűségalapú kutatásokat folytatta. Ez inkább a statisztikai és mérnöki tanszékekről indult. Az 50-es évek végén és a 60-as évek elején egyre-másra születtek a „zajos csatorna”-metaforán alapuló fejlesztések. Mosteller és Wallace 1964-ben arra alkalmazták a módszert, hogy megállapítsák, kik voltak a The Federalist különböző cikkeinek szerzői. A 60-as évekhez köthető egy másik fontos esemény is: az első online korpusz létrehozása, amely 1 millió szóból áll, ötszáz, különböző műfajú szövegből válogatva. Ez a Brown Corpus, amit a Brown University-n hoztak létre 1963-64-ben, Henry Kučera és W. Nelson Francis vezetésével. Ez egyébként máig az egyik legsűrűbben alkalmazott korpusz a számítógépes nyelvészetben.

Középkor, felnégyelés: 1970–1983

A következő periódusban a beszéd- és nyelvfeldolgozó fejlesztések robbanásszerű növekedését láthatjuk. Négy paradigma dominálja a területet.

A sztochasztikus paradigma komoly szerepet töltött be a beszédfelismerő alkalmazások terén. A statisztikai nyelvészet fellegváraiban, az IBM-nél, az AT&T laboratóriumaiban és a Carnegie Mellon egyetemen komoly kutatások folytak a rejtett Markov-modellek és a ”zajos csatorna”-modell felhasználásával.

A szimbolikus paradigma követői a 70-es években olyan MI-rendszereket fejlesztettek, melyek a nyelvfeldolgozás érdekes aspektusait demonstrálták – de csak nagyon korlátozott területeken, mint például Terry Winograd SHRDLU rendszere, aminek játékvilágában játékelemeket lehetett mozgatni természetes nyelvi (pontosabban angol nyelvű) parancsokkal.

A másik két paradigma szintén a szimbolikus paradigmából fejlődött: a logikai alapú és a diskurzusmodelláló, ami azt mutatja, hogy a 80-as évek elején egyértelműen a kézzel kódolt szimbolikus nyelvtanok és tudásbázisok uralták a terepet.

Újkor: az empirizmus visszavág: 1983–1993

Ez a korszak az 1950–60-as években háttérbe szorult modellek két osztályának visszatérését hozta. Az egyik a véges állapotú gépek, a másik a valószínűségi modellek. A statisztikai módszerek új erőre kapását az indokolta, hogy a beszédfelimerésben a ”zajos csatorna”-modellel jobb eredményeket értek el, mint a szabályalapúval.

A korpuszalapú tanulásban az első sikereket a szófaji egyértelműsítés terén érték el. Ennek lényege, hogy a szövegben előforduló szavakról a számítógép mondja meg, hogy melyik szófajhoz tartoznak. A szófaji egyértelműsítés nagyon hasznos előkészítő lépése lehet a mondatelemzésnek, a beszédszintetizálásnak vagy az információkinyerésnek.

Hasonló korai befolyásoló eredmény volt a gépi fordítás statisztikai megközelítése: a kanadai parlament kétnyelvű anyagain tanították be és tesztelték a módszert. A treebankek (szintaktikailag elemzett mondatok adatbázisai) fejlesztésével az empirikus mondatelemzési módszerek előtt is megnyílt az út.

Vissza a filozófiatörténetbe!

A hagyományos racionalista nyelvfeldolgozó módszerek kézzel kódolt szabályokon alapulnak. A nyelvfeldolgozó „gépbe” a szöveg mellett ez megy be, és így kapjuk az elemzést. Abban minden szakirodalom egyetért, és nehéz is lenne cáfolni, hogy a nagyon nagy lexikai erőforrásokat bonyolult és drága kézzel előállítani. Nagy és specifikus szakértelmet kíván, és rengeteg munkaráfordítást igényel. Ráadásul az így készített rendszerek teljesen területspecifikusak: más feladatra, vagy akár egy más műfajú szövegre nem lehet átvinni őket.

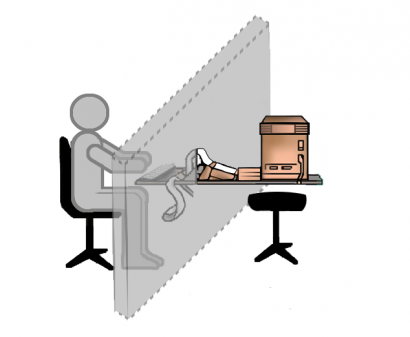

Az elemzésnél használt szabályrendszert a nyelvész saját magán végzett introspekció, azaz önmegfigyelés útján építi. A klasszikus nyelvészeti adatok tulajdonképpen emberi benyomások és ítéletek. Minden nyelvészeti adat egy kis informális pszicholingvisztikai kísérleten alapul, amit a nyelvész önmagán végez el. Ezeket az adatokat pontos, releváns és egzakt adatoknak tekinteni csak akkor lehet, ha azt feltételezzük, hogy az emberben megvan az a nyelvi tudás, amivel dönteni tud egy grammatikalitási kérdésben, azaz abban, hogy egy nyelvi szerkezet helyes (létező) vagy helytelen (nem létező).

(Forrás: Wikimedia commons)

Ez a kérdés visszavezet a 17. századba, a racionalizmus és az empirizmus közötti metafizikai viták korába. Descartes és Leibniz foglalták el a racionalista pozíciót: azt állították, hogy minden igazság eredete az emberi gondolkodásban és a születéstől az elménkben levő, úgynevezett innát (velünk született) ideák létezésében van. (Nem nehéz felismerni, hogy ez sokban hasonlít arra, amit Chomsky mond a nyelvről.)

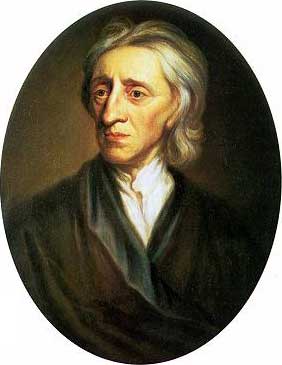

(Forrás: Wikimedia commons)

Ezzel az ortodox gondolkodással mentek szembe az empiristák, akik amellett érveltek, hogy az érzékszervi tapasztalat elsőbbséget élvez a velünk született képességekkel szemben. Locke és társai szerint tudásunk elsődleges forrása a tapasztalat, és az emberi értelem másodlagos szerepet játszik. A fő kérdés, ami következik ebből a vitából: milyen mértékben bír a nyelvi tapasztalat, illetve a velünk született nyelvi képesség a nyelvről való tudásunk alapjául szolgálni?

(Forrás: Wikimedia commons)

Amikor tehát a nyelvész önmegfigyelést végez annak érdekében, hogy eldöntse egy mondatról, hogy része-e a nyelvnek, akkor a következő kérdések merülhetnek fel benne: „Mondhatom én ezt?”, „Jó ez a mondat?”, „Ez azt jelenti?” vagy „Kétértelmű?”. A chomskyánus generatív grammatika szerint egy ilyen kérdésre csak kétfajta választ lehet adni: igen vagy nem, 0 vagy 1. Az ellenkező irányzat képviselői amellett érvelnek, hogy a „jónak hangzik” ítélet nem kétértékű, hanem fokozatai vannak. Ezt a problémát jól kezeli a valószínűséggel súlyozott nyelvtan. Ebben a mondat egyik elemzése valószínűbb, mint a másik, de nem feltétlenül rossz bármelyik is.

Az egyik legnagyobb probléma a kétértékű grammatikalitási ítéletekkel és ezáltal a racionalista nyelvtanokkal, hogy egyáltalán nem hibatűrőek. Vegyük például a következő angol mondatot: Thanks for all you help (kb. ’Köszönjük minden te segítség’, de tanulságos a webforditas.hu megoldása is: ’Kösz mindent, aminek segítesz’). Ebből a mondatból csak egy betű maradt le ahhoz, hogy jó legyen (ha a you ’te’ helyett your ’tied’ állna, már jó lenne), de a chomskyánus generatív nyelvtan csak annyit tudna róla mondani, hogy rossz mondat. Ha elfogadjuk, hogy hasonló hibák megesnek, és bevezetünk valami korrekciós értéket, amit összekombinálunk a „jóság” további összetevőivel, akkor megkapjuk a „globális jóság”-nak az értékét, ami alapján ki tudjuk választani a legjobb elemzést. A hibatűrés egyáltalán nem tartozik a racionalista módszerek tulajdonságai közé, míg a statisztikai módszerek kifejezetten jók hibakeresésben és -korrekcióban, ami a shannoni „zajos csatorna”-metaforából következik. És valljuk be: magunk is így működünk. Észrevesszük ugyan a mondat rendhagyóságát, de képesek vagyunk „korrigálni”, feldolgozni, megérteni.

Az empirikus módszerek kategóriái

A legtöbb empirikus módszer úgy működik, hogy egy-egy szerkezettípushoz valószínűségi értéket kapcsol: azaz feltételezi (vagy korábbi adatokból kiszámolja), hogy egy adott szerkezettípus milyen gyakran fordul elő.

Vannak olyan empirikus módszerek is, amelyek nem használnak valószínűségi modelleket. Annak ellenére, hogy az empirizmus újjászületése elsősorban a valószínűséget használó modellekben mutatkozott meg, a szabályalapú tanulási technikák is igen elterjedtek. Természetesen minden tanulóalgoritmus használ statisztikai módszereket abban az értelemben, hogy a kiinduló adatokban található szerkezeteket statisztikai alapon dolgozza fel. Egy egyszerűsített példát véve: ha egy gépnek a nyelv mondattanát kell megtanulnia olyan kiinduló szövegekből, melyben a szavak szófaja meg van jelölve, akkor megvizsgálja, hogy mi a gyakoribb: ha egy melléknév a főnév előtt, vagy a főnév után áll. A gyakorisági adatokból aztán eldönti, hogy egy főnévnek a melléknév elé vagy utána kell-e kerülnie, de az általa készített nyelvtan már csak az egyiket engedi meg. A statisztikai modell szerint mindkettő előfordulhat, de különböző a valószínűségük. Lehet, hogy a gép végül egy olyan elemzést választ, amelyben a kevésbé valószínű szerkezet fordul elő, ha a mondatban azonosítható összes szerkezet valószínűsége még így is viszonylag magas – legalábbis a többi szóba jöhető elemzéshez képest.

A rendszerek eltérhetnek abban is, hogy a tanulóalgoritmus milyen bemeneti adatokat használ. Sok rendszer olyan tanulóadatokat használ, melyet emberi erővel elemeztek. A tanulás itt lényegében csak abból áll, hogy az emberek által használt szabályokat a gép statisztikai alapon megtanulja (például hogy ha egy melléknevet egy főnév követ, akkor a kettő általában egy szerkezeti egységet alkot). Más rendszerek csak nyers szövegeket használnak, és önállóan alakítják ki magukat az elemzéseket is. Mivel korpuszokat annotálni nehéz és időpazarló elfoglaltság, az utóbbi módszert szívesebben használják a számítógépes nyelvészek.

Guelphek és ghibellinek

Az alábbiakban nem az irányzatok, hanem azok képviselői: az elméleti és a korpusznyelvész közötti különbségeket szedtük össze szisztematikusan.

|

Az elméleti nyelvész |

A korpusznyelvész |

|

A nyelvi rendszer áll az érdeklődése fókuszában. |

A nyelvhasználat folyamata áll az érdeklődése fókuszában. |

|

Célja a nyelvi jelenségek és a nyelvhasználat magyarázata. |

Célja a nyelvi jelenségek és a nyelvhasználat leírása, ahogy azok megjelennek a szövegben. |

|

Elméletorientált a nyelvészethez való hozzáállása. |

Adatorientált a nyelvészethez való hozzáállása. |

|

A bonyolultságot preferálja az egyszerűséggel szemben, és a pontosságot a sebességgel szemben, még ha kis mintával is kell beérnie. |

Mérésekkel is megelégszik, ha azok nagy szövegen is gyorsak. Úgy gondolja, hogy együtt tud élni azzal a zajjal, amit módszerének egyszerűsége okoz. |

|

A kvalitatív módszereket preferálja. |

A kvantitatív módszereket preferálja. |

|

A racionalista tradíció örökösének érzi magát. |

Az empirista tradíció örökösének érzi magát. |

|

A szövegre mint egy absztrakt létezőre tekint. |

A szövegre mint egy fizikai produkcióra tekint. |

|

Célja az univerzális nyelvtan. |

Főleg az egyes nyelvek nyelvtana érdekli. |

|

Az alakra és a jelentésre fókuszál. |

Csak az alakra fókuszál. |

|

Mély elemzést végez szűk területeken. |

Felszínes, nem részletező elemzést végez nagy mennyiségű szövegen. |

|

A szabályalapú módszereket preferálja. |

A valószínűségi és statisztikai alapú módszereket preferálja. |

|

Az intuícióra és az önmegfigyelésre támaszkodik a nyelvi adatok gyűjtésénél. |

A nyelvi viselkedést kívülállóként figyeli meg. |

|

„Játék”-példákkal foglalkozik: elszigetelt, kontextusukból kiragadott mondatokkal. |

Eredeti, nem a nyelvi vizsgálat céljára létrejött adatokkal foglalkozik, azokat szövegkörnyezetükben vizsgálja. |

|

A deduktív módszerben hisz. |

Az induktív módszerben hisz. |

Békeharc

Végül fontos közölni, hogy a racionalista és az empirista módszerek nem összeegyeztethetetlenek. A két módszer összehangolásának egyik tipikus példája a modern lexikográfia. Az empirikus kutatások azt mutatják, hogy a szavaknak nem jól elszigetelt jelentéseik vannak, hanem bizonyos tipikus jelentéseik, melyek bizonyos utakon-módokon (pl. metaforával, metonímiával) rugalmasan tágíthatóak. A modern lexikográfiában a szavak jelentését, használati szabályaikat már nem a szótáríró intuíciója alapján, hanem rengeteg szöveganyag alapos átvizsgálásával állapítják meg, ugyanakkor a szótárban ezek a hagyományos elképzelésnek megfelelően, azaz úgy jelennek meg, mintha a szónak valóban élesen elkülönülő jelentései lennének. Igaz, a korpuszalapú szótárakat ma már gyakran statisztikai adatokkal is kibővítik.

Mindent egybevéve: „észre kéne vennünk, hogy a dolgok nem olyan polarizáltak (ha egyáltalán azok), mint amennyire mutatják magukat: néhány kutató felfedezi a statisztikai alapú technikák értékét a szabályalapú világban, és vice versa.” (John McNaught)

Felhasznált és ajánlott irodalom

Jurafsky, Daniel and Martin, James H., Speech and Language Processing. An Introduction to Natural Language Processing, Computational Linguistics, and Speech Recognition. Prentice Hall, New Jersey, 2000.

Turing, A. M., On computable numbers, with an application to the Entscheidungsproblem. In: Proceedings of the London Mathematical Society, 42, 230–265.

Kleene, S. C., Representation of events in nerve nets and finite automata. In: Shannon, C. and McCarthy, J. (eds.), Automata Studies, 3–41. Princeton University Press, Princeton, 1956.

Shannon, C. E., A hírközlés matematikai elmélete. In: Shannon, C. E.–Weaver, W., A kommunikáció matematikai elmélete. Az információelmélet születése és távlatai. Országos Műszaki Információs Központ és Könyvtár, Budapest, 1986.

Chomsky, N., Mondattani szerkezetek. In: Chomsky, N., Mondattani szerkezetek–Nyelv és elme. Osiris Kiadó, Budapest, 1999.

Lager, T., A logical approach to computational corpus linguistics. Doctoral Dissertation, Göteborg University, Sweden, 1995.

McNaught, J., User Needs for Textual Corpora in Natural Language Processing. Literary and Linguistic Computing 8(4), 227-234.