-

ganajtúrós bukta: @Sándorné Szatmári: Szóval nem válaszolsz helyette ezt csinálod: hu.wikipedia.org/wiki/Ign...2025. 07. 02, 00:27 Mi bizonyítja, hogy a magyar nyelv finnugor?

-

Sándorné Szatmári: @szigetva: @ganajtúrós bukta: Gondolom az átalános relativitás számunkra nyelvi téren érte...2025. 07. 01, 21:08 Mi bizonyítja, hogy a magyar nyelv finnugor?

-

ganajtúrós bukta: @Sándorné Szatmári: Nem válaszoltál a kérdésemre. Mivel magyarázod a videót amit belinkelt...2025. 07. 01, 18:44 Mi bizonyítja, hogy a magyar nyelv finnugor?

-

szigetva: @Sándorné Szatmári: Szinte mindenkinek van keze, lába, fia, lánya; kisebb számok, nap, hol...2025. 06. 30, 13:04 Mi bizonyítja, hogy a magyar nyelv finnugor?

-

Sándorné Szatmári: @szigetva: 744 Kiegészítésem: Az "alap szókincs" sem egyértelmű, mert mihez képest alap.. ...2025. 06. 30, 12:57 Mi bizonyítja, hogy a magyar nyelv finnugor?

Kálmán László nyelvész, a nyest szerkesztőségének alapembere, a hazai nyelvtudomány és nyelvi ismeretterjesztés legendás alakjának rovata volt ez.

- Elhunyt Kálmán László, a Nyelvész, aki megmondja

- Így műveld a nyelvedet

- Utoljára a bicigliről

- Start nyelvstratégia!

- Változás és „igénytelenség”

Kálmán László korábbi cikkeit itt találja.

Ha legutóbb kimaradt, most itt az új lehetőség!

Ha ma csak egyetlen nyelvészeti kísérletben vesz részt, mindenképp ez legyen az!

Finnugor nyelvrokonság: hazugság

A határozott névelő, ami azt jelenti, hogy ‘te’

Az oroszok már a fejünkön vannak!

A gépek nem lehetnek rasszisták. A gépek logikusak. Vagy mégsem? Az ártatlan algoritmusok is csúnyán előítéletes döntéseket hozhatnak – és gyakran hoznak is. Nem ők tehetnek erről, hanem mi.

Amikor álmai lakásához hitelt vesz fel a kedves olvasó, mit szeretne jobban: egy kedves banki alkalmazott kérdezze végig hogyan érzi magát mostanság, mennyire tud takarékoskodni, milyen gyakran vált munkahelyet, mennyit szokott betegeskedni, lesznek-e majd gyerekei, stb. vagy inkább egy standard kérdőívet töltene ki, megadná hiteltörténetét, jelenlegi keresetét és pár egyéb adatot egy algoritmusnak és egy hideg gépre bízná a döntést? Többségünk valószínűleg inkább bízná egy pártatlan gépre a döntést, hiszen a gépet nem érdekli nemünk, bőrszínünk, vagy az, hogy a hitelkérelem napján rossz napunk van és nem a legjobb arcunkat mutatjuk a világnak éppen. Ez jól is hangzik, de az ártatlan algoritmusok nagyon gyakran olyan adatokkal dolgoznak, amik remekül újratermelik az emberi előítéleteket és koránt sem objektív döntéseket hoznak.

Cserfes kislányoknak nem való a beszédfelismerés

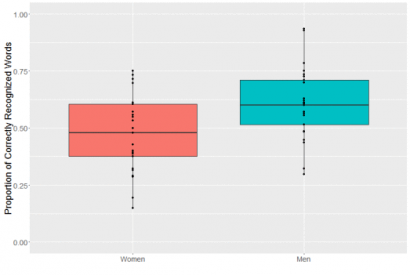

A Google beszédfelismerőjével kapcsolatban már többször felmerült, hogy a női beszéddel nehezebben boldogul, nem kicsit, nagyon.

(Forrás: makingnoiseandhearingthings.com)

A válasz erre gyakran az, hogy hát a nők olyan kis cserfesek, gyorsan beszélnek, nem artikulálnak bele a mikrofonba, meg halkak is. A baj ezzel az, hogy a statisztikák szerint a nők lassabban és tisztábban beszélnek, de persze halkabbak anatómiai adottságaik miatt. Ezeket a problémákat azonban simán lehetne orvosolni, ha a beszédfelismerők betanítására használt adathalmazokban megfelelően lennének a női beszélők reprezentálva.

Mi a hiba a képen?

Nagyon nehéz beszerezni beszédfelismeréshez használt adatbázisokat (vagy korpuszokat), hogy alaposan megvizsgáljuk, ténylegesen felülreprezentáltak a férfi beszélők. A Google, vagy a Microsoft általában saját korpuszt szokott építeni, ami rengeteg pénzbe kerül, ezért nem adják csak úgy ki ezeket.

A mesterséges intelligencia egy másik ágában, a képfeldolgozásban azonban nagyon divatosak a szabadon felhasználható adathalmazok. Az egyik ilyen népszerű adathalmaz a Flickr30k, ami a Flickr képmegosztó oldalon található szabad felhasználású képeket és rövid leírásukat tartalmazza. Az adathalmaz úgy készült, hogy a MechanicalTurk nevű oldalon dolgozó embereket bízták meg azzal, írják le egy-egy kép információtartalmát. A képfeldolgozás egyik népszerű feladata, hogy még nem látott képekhez generáljunk leírásokat, ehhez jönnek jól az ilyen adathalmazok.

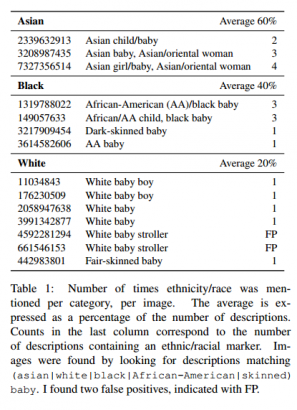

Emiel van Miltenburg ezt az adathalmazt vizsgálva jutott arra, hogy a leírásokkal valami nincs rendben. A leírásokról feltételezzük, hogy azok semlegesek és arra törekednek, hogy csak a képen látható dolgokat írják le, csakhogy ezekbe a leírásokba óhatatlanul belekerültek bizonyos sztereotípiák. Például a gyermekeket ábrázoló képeknél, ha nem fehér babákról van szó, nagyon gyakran bekerültek etnikai jelzők, pl. black baby, asian baby, stb. Az alábbi táblázat ezt nagyon remekül összefoglalja:

Vagy éppen az ázsiai embereket mutató képeken rendszeresen megemlítik hogy „Japanese people”, „Chinese people”, azaz egy adott etnikumhoz sorolják őket. De talán a legszebb példa az előítéletek beszivárgására a 8063007 azonosítóval rendelkező kép, melyhez az alábbi leírások tartoznak:

-

Egy szőke lány és egy kezeit keresztbe tevő kopasz férfi egymással szemben állnak

-

Egy munkást éppen kioktatóan lehord a főnöke

-

Egy menedzser egy munkással beszél a teljesítményéről.

-

Egy szőke jó csaj kritikát kap a főnökétől.

-

Sonic (gyorsétterem lánc) alkalmazottak a munkájukról beszélgetnek.

.

Gépi előítéletek

Aki szeretne nagyokat csodálkozni és őszintén felháborodni azon, hogy rossz adatokon, vagy éppen rosszul betanított algoritmusokkal hogyan lehet óvatlanul, vagy szándékosan tönkretenni emberek életét, netán csődbe vinni cégeket, azoknak Frank Pasquale The Black Box Society könyvét ajánljuk. Itt csak két nagyon egyszerű példán keresztül próbáljuk megmutatni, miért baj ez.

Történt egyszer, hogy Latanya Sweeney egyik tanulmányát szerette volna egy kollégája beszerezni. Sweeney erre a Google szolgáltatását ajánlotta nevével és pár kulcsszóval. A kedves kolléga megdöbbent, hogy az első, úgynevezett szponzorált találatok között szerepelt egy szolgáltatás, ami az adott személy előéletének feltérképezését ajánlotta a volt-e büntetve Latanya Sweeney? kérdéssel.

Miután a kutatók kipróbálták, milyen eredményeket kapnak több inkább fehérekre, vagy inkább feketékre jellemző névvel, olyan mennyiségű anyagot tudtak gyűjteni, hogy végül egy csinos tanulmányt is tudtak írni belőle.

Persze, nem arról van szó, hogy a Google rasszista. A hirdetési felületen a hirdetők licitálnak, hogy egy-egy kulcsszóhoz tartozó találatoknál az ő fizetett tartalmuk jelenjen meg. Ha nyertek, akkor az adott találati oldalon megjelenik a hirdetésük; ha szerencséjük van, akkor valaki rákattint a hirdetésre, ha még szerencsésebbek, akkor a kattintás után vásárol náluk valamit az illető. A licitáló rendszerek is általában automatikusak és tanulnak. Mivel feketének hangzó neveknél sokkal többen kattintottak a szolgáltatás reklámjára és általában nem a semleges „ismerje meg X hátterét”, hanem a „volt-e X büntetve” szöveggel, ezért a fekete nevekhez társította a negatív felvetést sugalmazó kérdést a rendszer. Ez még önmagában nem lenne baj, csak hát manapság, amikor megpályázunk egy állást, (vagy akár csak megismerkedünk valakivel, és valamiért rákeresünk), ez a jelenség kimondottan igazságtalan és hátrányos – már amennyiben egyáltalán fontolóra veszünk egy olyan embert, akinek a neve nem szokványos, vagy szokványos, de a többségi társadalométól eltérő norma szerint az. Hiszen mit szeretnénk mi magunk látni a hirdetések között: hogy azt ajánlja valaki hogy megtudhatja nála, voltunk-e büntetve, vagy inkább azt, hogy leellenőrizhetik-e a hátterünket? Mit gondolna ön arról, akinek a neve mellett szerepel eldöntendő kérdésként, hogy volt-e büntetve?

Az Egyesült Államokban a rendőri munkát egyre többször segítik kockázatelemző szoftverek. Elvileg ezeknek a dolga lenne, hogy segítsék a rendőröket abban, hogy egy-egy gyanúsítottal szemben arányosan tudjanak fellépni munkájuk során. Ezek a kockázatelemző szoftverek múltbeli esetek leírásaiból alakítottak ki maguknak modelleket, ezért amikor megkérdezik őket, hogy X.Y. mekkora kockázatot jelent, megpróbál X.Y.-hoz hasonló eseteket keresni s azokra alapozva tippelni.

(Forrás: JD Hancock / Flickr / CC BY 2.0)

Ahogy a Pro Publica riportjából is kiderül, a feketéket és latinókat ezek a szoftverek rendre magasabb kockázatúnak találják, mint a fehéreket. De miért van ez így? Nem lehet, hogy minden rasszizmust félretéve is az van, hogy a gazdaságilag elmaradottabb, iskolázatlanabb rétegek körében magasabb a bűnözés – és hát ők történetesen éppen a kisebbségek tagjai közül kerülnek ki? Nem lehet ésszerű magyarázat, hogy a szegényebb, kisebbségi elkövetőkhöz általában inkább erőszakos cselekmények köthető, míg a „rendes fehér középosztály” inkább gazdasági bűncselekményeket követ el?

Nyilvánvaló, hogy a jelenség összetett, de annyi bizonyos, hogy a rendszer betanításához használt adatokban is akad hiba bőven. Elég csak a TASZ Jogtalanul programjára gondolni, hogy megértsük mi lehet a hiba. Ha a rendőrök eleve nagyobb számban állítanak meg romákat azért, mert nincsen rajtuk láthatósági mellény, nincs kellően kivilágítva kerékpárjuk, vagy éppen nem jelezték az üres úton, hogy balra kanyarodnak, akkor elve olyan adatok keletkeznek, amelyekben utalunk arra, hogy ilyen cselekményeket romák követnek el. Nem kell rögzítenünk, hogy az illető roma! Elég a lakhelyét, nemét, foglalkozását, a bírságolás helyét, stb. rögzíteni, máris lefedtünk még pár tucat hasonlót, aki magas kockázatú szabálysértőnek tekinthető és történetesen roma.

Az oldal az ajánló után folytatódik...

Van remény?

Szerencsére a kutatók elkezdték szisztematikusan feltárni a jelenlegi adathalmazok és a rájuk alapozott algoritmusok hiányosságait. Az Európai Unió külön szabályozással próbál rendet tenni (General Data Protection Regulation), ami nem csak a személyekről gyűjtött adatok átláthatóságát és ellenőrizhetőségét teremti meg, hanem megköveteli, hogy minden, ezen adatokra alapozott döntésnek transzparensnek kell lennie. Ez nagyon jól hangzik, csak sajnos nagyon nehéz megfelelni neki, de erről egy későbbi írásban fogunk majd szólni.